Non, les assistants IA ne sont pas de doctes conseillers…

On s’y laisse prendre (du moins est-ce le cas pour une part non négligeable – et grandissante – des patients internautes…) : l’“avis” d’un assistant “intelligent” IA (du genre ChatGPT) est considéré comme outil fiable suite à une question concernant la santé, un ou plusieurs symptômes, un remède recherché…

Or, une étude (scientifique, elle) récente réalisée outre-Manche auprès de 1.298 participants, citoyens lambda représentatifs de la population britannique, a démontré que les réponses données ne sont en rien de meilleure qualité – ou fiabilité – qu’une recherche (raisonnée) via moteur de recherche. Ce serait plutôt le contraire qui serait vrai.

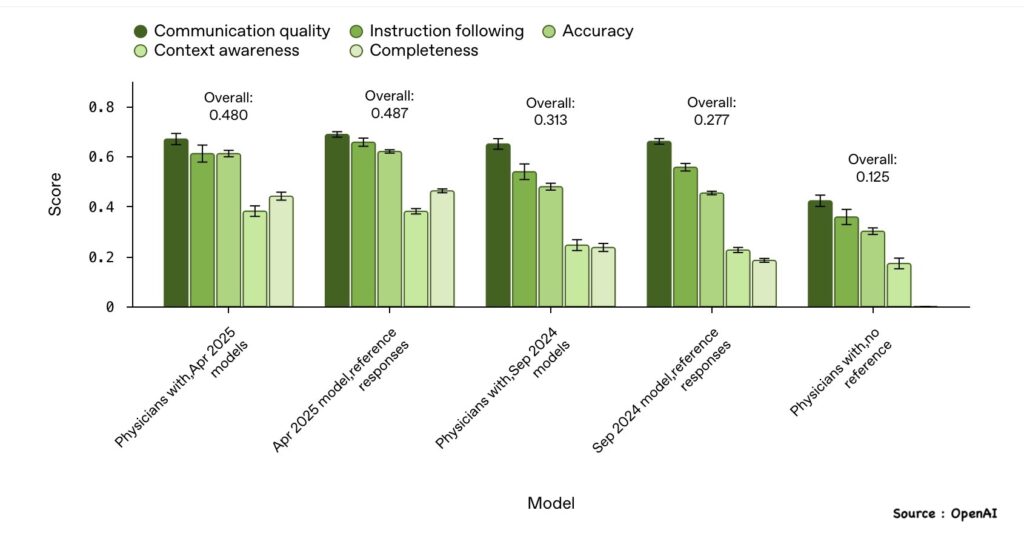

L’étude en question, dont les résultats ont été publiés dans Nature Medicine, a comparé divers modèles LLM (GPT-4o d’OpenAI, Llama 3 de Meta, Command R+ de Cohere), en demandant aux participants de recourir, pour un premier groupe, aux LLM mis sur la sellette et, pour un groupe témoin, à des outils de recherche traditionnels, afin de fournir un diagnostic face à dix ensembles de symptômes, reconnus par le corps médical.

Résultat : les LLM ne font pas mieux qu’une simple recherche. Seulement un peu plus d’un tiers des participants (37%) ont réussi à identifier correctement la pathologie concernée. Soit jusqu’à 20% moins bien que les membres du groupe témoin qui ont donc mieux réussi l’exercice en recourant soit à un moteur de recherche, soit en procédant par recherche directe sur un site fiable (notamment celui du NHS).

Cela tient notamment, selon les auteurs de l’étude, à la manière, parfois imprécise ou trompeuse, dont de “simples” patients formulent la question ou fournissent des informations (pas forcément complètes, précises ou pertinentes)…

Preuve en est que les outils IA se sont montré nettement plus précis et efficaces, approchant mieux le bon diagnostic, lorsque les questions, concernant les mêmes symptômes, étaient formulées par des médecins… Résultat selon ce deuxième scénario-là : 95% de précision pour ChatGPT, 99% pour LLama 3, 91 % pour Command R+.

Certes, les LLM s’améliorent mais comme le dit un expert en bioéthique de l’université de Maastricht, cité par le média français La Tribune, “cette étude […] souligne que les chatbots présentent de vrais risques médicaux pour le grand public”.

Commentaire similaire d’un spécialiste en “IA responsable” et en santé numérique de l’université de Mannheim, cité dans Le Monde : “[L’étude] montre qu’un chatbot sans garde-fous, sans questionnement structuré, sans une conception centrée autour de l’utilisateur, n’est pas encore prêt pour l’auto-diagnostic”.

A lire, les résultats de l’étude “Reliability of LLMs as medical assistants for the general public: a randomized preregistered study”, publiés dans Nature Medicine.

Réponses