OpenAI propose un outil d’évaluation des LLM dans le secteur de la santé

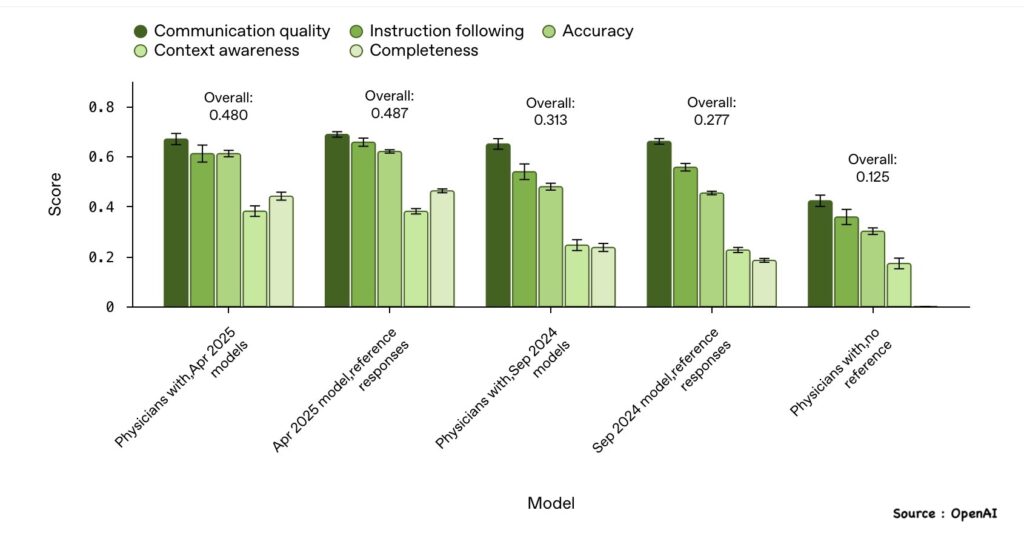

OpenAI a sollicité la collaboration de quelque 262 médecins (de diverses nationalités) en vue de mettre au point un benchmark, baptisé HealthBench, qui a pour but d’évaluer la sécurité et la performance des LLM (grands modèles de langage) dans le domaine de la santé.

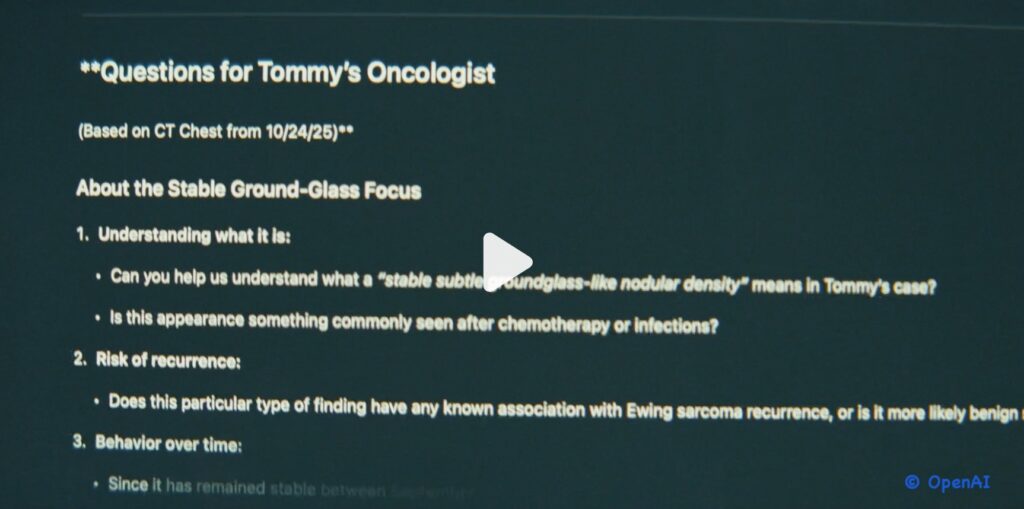

Ce référentiel HealthBench a été bâti sur base de quelque 5.000 conversations et échanges entre professionnels de santé et patients, “chacun accompagné d’une grille d’évaluation personnalisée rédigée par un médecin pour noter les réponses des modèles.”

Pour se rapprocher le plus possible de la réalité sur le terrain, ces conversations, affirme OpenAI, ne se sont pas limitées à “de simples questions d’examen mais ont inclus des scénarios complexes et réalistes qui reproduisent les interactions entre les personnes, les professionnels de santé et les modèles d’IA.”

HealthBench opère sur sept thèmes, notamment des situations d’urgence, la gestion de l’incertitude et la santé mondiale. Chaque thème “comporte des exemples pertinents, assortis de critères d’évaluation spécifiques”, critères pondérés en termes d’importance clinique, “ce qui permet d’évaluer les modèles sont selon une grille d’analyse. Chaque réponse du modèle est notée selon une série d’exigences rédigées par des médecins, spécifiques à chaque conversation.”

L’évaluation des réponses générées par le modèle est assurée par un “système automatique basé sur GPT-4.1, qui vérifie si chaque critère est respecté, et calcule un score total comparé au score maximal possible.”

L’outil d’évaluation et les données utilisées sont disponibles via le dépôt GitHub d’Open AI.

Autres documents :

– “Introducing HealthBench : An evaluation for AI systems and human health”.

– “HealthBench: Evaluating Large Language Models Towards Improved Human Health”, publié par OpenAI.

Source : L’Usine Digitale

Réponses