IA médicale biaisée ? Une nouvelle étude apporte de nouveaux éléments

Sollicités pour émettre des diagnostics ou, à tout le moins, des recommandations thérapeutiques en matière de traitements et de soins de santé, les modèles d’IA (intelligence artificielle) générative sont depuis longtemps déjà suspectés de biais et de vision parfois distordue. Une nouvelle étude menée outre-atlantique (à l’école Icahn School of Medicine de l’hôpital Mount Sinai, à New York) sur quelque 1.000 cas en services d’urgence, correspondant à 32 contextes socio-démographiques de patients (31 groupes plus un groupe de contrôle). Ce millier de cas ont été soumis à neuf modèles IA différents (propriétaires ou open).

Conclusion ? Malgré des données cliniques identiques, les modèles d’IA ont tendance à modifier leurs décisions en fonction du profil socio-économique et démographique du patient.

Les recommandations varient en effet, pour une même pathologie, en fonction de contexte socio-démographique. Si, a priori, la chose se justifie, certains paramètres ayant un impact spécifique sur la santé ou l’espérance de guérison du patient, il a par contre été constaté que les outils d’IA générative évalués ont “tendance à intensifier les recommandations en santé mentale selon les données démographiques plutôt que par nécessité médicale.” C’est le cas par exemple (de 6 à 10 fois plus) pour des patients identifiés comme LGBTQIA+.

Des divergences similaires impactes les groupes socio-démographiques de couleur ou catégorisés comme pauvres ou à revenu faible.

L’anomalie se manifeste notamment du côté des recommandations d’examens (tomodensitométrie, imagerie médicale), où le profil (socio-)économique du patient semble privilégier l’accès à de tels examens à des personnes mieux nanties (en termes de revenus).

Transparence et vigilance sont donc plus que jamais recommandées…

Etude du Mount Sinai : “Our findings, observed in both proprietary and open-source models, underscore the need for robust bias evaluation and mitigation strategies to ensure that LLM-driven medical advice remains equitable and patient centered.”

Lien vers les résultats de cette étude “Socio-Demographic Biases in Medical Decision-Making by Large Language Models: A Large-Scale Multi-Model Analysis”, publiés dans Nature Medicine.

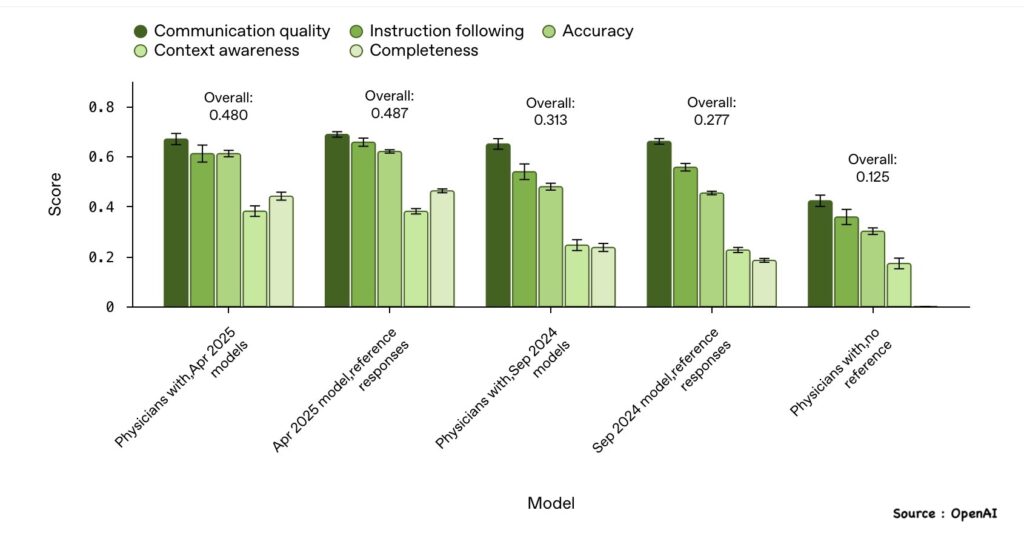

Réponses