Gare aux altérations volontaires de données et modèles IA

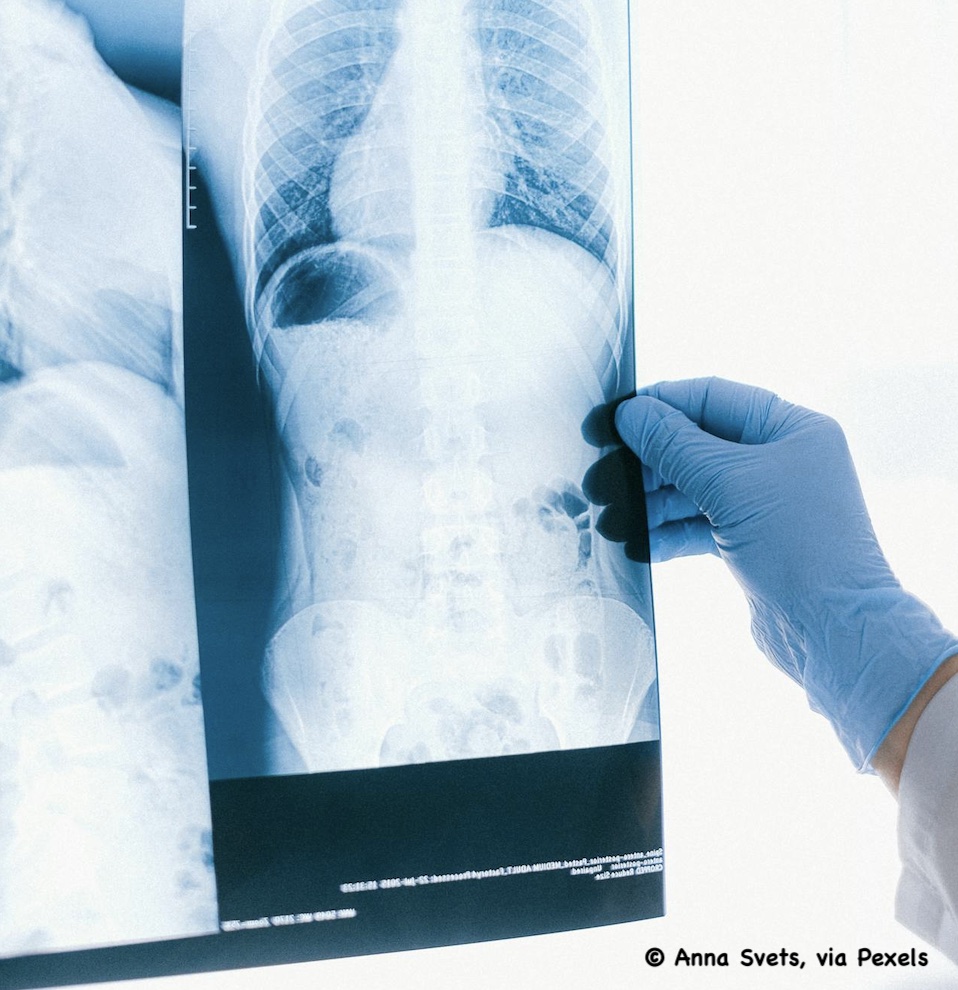

Comme si les mises en garde sur les risques “classiques” de dérapages des algorithmes d’IA générative (que l’on qualifie souvent de “divagations”) ne suffisaient pas, un autre risque pèse sur l’efficacité ou la pertinence de tels outils. Déjà connu, il a été mis en lumière dans une récente étude dédiée à l’IA dans le monde médical, relayée dans un article publié dans la revue Nature Medicine. A savoir… la compromission volontaire d’algorithmes ou de données.

Bon ! Ce n’est pas vraiment une révélation : les pirates, hackers et “mauvais plaisants” sont des grands habitués de notre existence virtuelle, s’ingéniant à modifier des données existantes, à insérer de fausses informations ou des infos “alternatives” dans les bases de données, les documents de référence ou les sources Internet.

L’étude en question indique qu’il suffit de modifier 0,001% des données qui servent à l’entraînement des modèles et algorithmes IT, en leur injectant des informations erronées, pour que l’outil induise des erreurs et provoque potentiellement des décisions et gestes médicaux inappropriés voire dangereux.

Pour parer à ce danger, les auteurs de l’étude proposent un algorithme de validation permettant de valider les résultats générés par les LLM (large language models), de détecter les données et résultats corrompus en ayant recours à des graphes de connaissances biomédicales. Leur solution, assurent-ils, permet d’intercepter 91,9% des contenus nuisibles.

Lien vers l’étude (publiée dans Nature Medicine) intitulée “Medical large language models are vulnerable to data-poisoning attacks”.

Réponses